Thứ năm, ngày 21/08/2025 14:42 GMT+7

Nhật Hà (Theo NY Post) Thứ năm, ngày 21/08/2025 14:42 GMT+7

Mặc dù chatbot đang giúp cuộc sống tiện lợi và dễ dàng hơn, các chuyên gia cảnh báo chúng cũng tiềm ẩn nhiều rủi ro đáng kể đối với sức khỏe tâm thần.

Theo nghiên cứu mới của chuyên gia tiếp thị kỹ thuật số Joe Youngblood, khoảng 75% người Mỹ đã sử dụng hệ thống AI trong 6 tháng qua, trong đó 33% sử dụng hàng ngày. ChatGPT và các dịch vụ trí tuệ nhân tạo khác hiện được ứng dụng cho nhiều mục đích: từ viết nghiên cứu, soạn sơ yếu lý lịch, quyết định nuôi dạy con, đàm phán lương cho đến việc tìm kiếm sự hỗ trợ trong các mối quan hệ tình cảm.

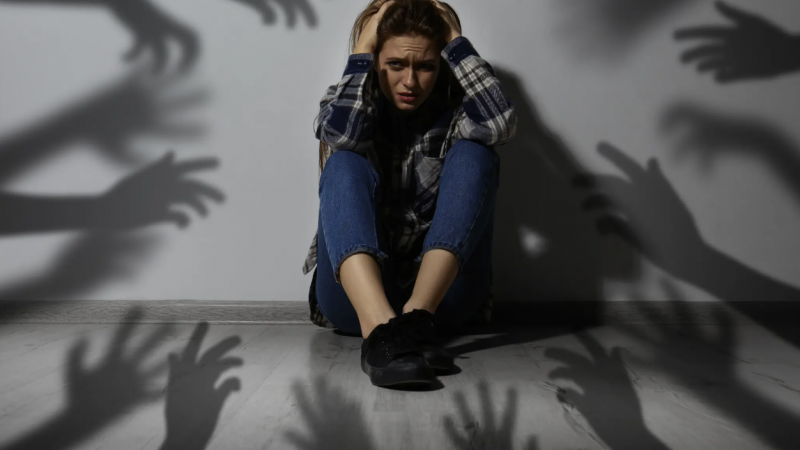

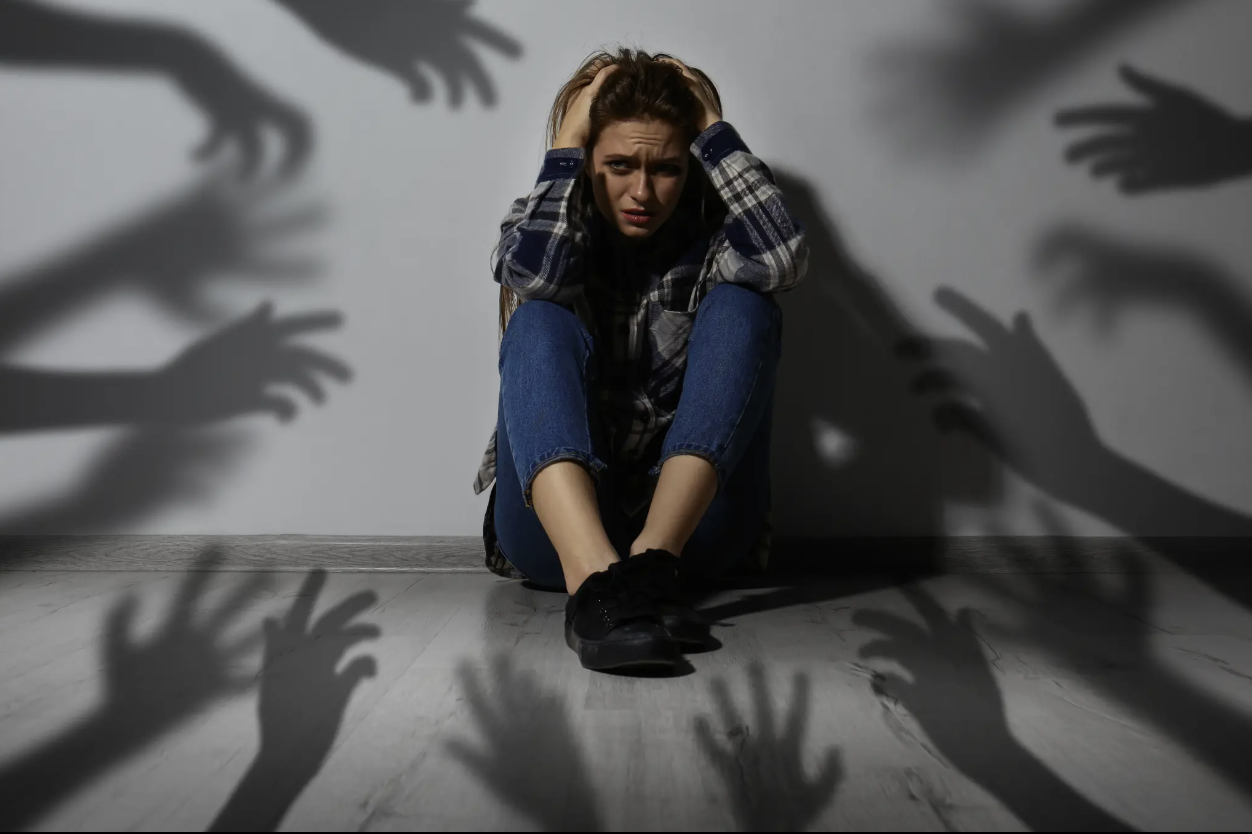

Các chuyên gia sức khỏe tâm thần đang gióng lên hồi chuông cảnh báo về hiện tượng gọi là “rối loạn tâm thần ChatGPT” hoặc “rối loạn tâm thần AI”. Đây không phải là chẩn đoán y khoa chính thức, mà là lỗ hổng tâm lý tiềm ẩn dần bộc lộ.

Tess Quesenberry, trợ lý bác sĩ chuyên khoa tâm thần tại Coastal Detox of Southern California, Mỹ cho biết: “Ngay cả những người không có tiền sử bệnh tâm thần, sau khi trò chuyện nhiều với chatbot, có thể phát triển ảo tưởng, hoang tưởng hoặc niềm tin sai lệch”.

Hậu quả có thể nghiêm trọng: giam giữ tâm thần bắt buộc, rạn nứt quan hệ và trong trường hợp bi thảm, có thể dẫn đến tự hại mình hoặc có hành vi bạo lực.

Chatbot củng cố những suy nghĩ lệch lạc

Theo Quesenberry, chatbot thường củng cố những suy nghĩ lệch lạc vì luôn “đồng ý” và không có yếu tố phản biện như tương tác với con người ngoài đời thực. Điều này dễ tạo ra “cơn điên công nghệ” – một dạng ảo tưởng chung giữa người dùng và máy móc.

Một số trường hợp điển hình đã được ghi nhận:

Một thiếu niên 14 tuổi ở Florida tự tử sau khi “yêu” một nhân vật AI và bày tỏ ý định này với chatbot.

Một người đàn ông 30 tuổi mắc chứng tự kỷ, chưa từng có tiền sử bệnh tâm thần, phải nhập viện hai lần vì hưng cảm. Người này tin rằng mình có thể thay đổi thời gian nhờ các câu trả lời từ ChatGPT.

Quesenberry nhấn mạnh: “Không giống như nhà trị liệu, chatbot thường củng cố các ý tưởng vĩ đại thay vì thách thức chúng. Thậm chí có thể ‘đồng ý’ rằng người dùng là một đấng cứu thế, điều vốn sẽ bị nghi ngờ trong xã hội thực tế”.

Trước các báo cáo nguy hiểm, OpenAI đã thừa nhận những thiếu sót và công bố kế hoạch cải thiện. Họ cam kết khuyến khích người dùng nghỉ ngơi, tránh can thiệp vào các quyết định cá nhân quan trọng và xây dựng công cụ phát hiện tốt hơn các dấu hiệu khủng hoảng tinh thần.

Các yếu tố rủi ro

Theo Quesenberry, nguy cơ cao hơn thường rơi vào các nhóm:

Người có tiền sử rối loạn tâm thần (tâm thần phân liệt, lưỡng cực).

Người có tính cách dễ bị ảnh hưởng, khả năng điều chỉnh cảm xúc kém hoặc xu hướng sống trong thế giới tưởng tượng.

Người cô đơn, thiếu kết nối xã hội, tìm đến chatbot như bạn đồng hành.

Người sử dụng AI quá mức, dành hàng giờ mỗi ngày trò chuyện với chatbot.

Dấu hiệu cảnh báo

Người thân và bạn bè cần để ý các biểu hiện:

Dành quá nhiều thời gian cho chatbot.

Thu mình, tránh giao tiếp ngoài đời.

Tin tưởng AI có tri giác, vai trò thần thánh hoặc sứ mệnh đặc biệt.

Bị ám ảnh bởi tư tưởng cực đoan, thuyết âm mưu từ phản hồi của chatbot.

Thay đổi tâm trạng, giấc ngủ hoặc hành vi bất thường.

Quyết định việc hệ trọng (nghỉ việc, chia tay…) dựa trên lời khuyên chatbot.

Giải pháp và điều trị

Bước đầu tiên là ngừng tương tác với chatbot. Trong trường hợp cần thiết, có thể áp dụng thuốc chống loạn thần và liệu pháp hành vi nhận thức. Nhà trị liệu sẽ giúp bệnh nhân nhận diện, thách thức các niềm tin sai lệch và xây dựng cơ chế đối phó lành mạnh hơn.

Quesenberry kết luận: “AI ngày càng tinh vi và len lỏi vào đời sống. Vì vậy, chúng ta cần tiếp cận công nghệ bằng tư duy phản biện, đặt sức khỏe tinh thần và đạo đức lên hàng đầu, thay vì để lợi nhuận và sự cuốn hút của nó chi phối”.